Хранение и запуск сценариев ETL (DAGs Airflow)

Обновлено 09 марта 2023

Созданный сценарий (DAG) перемещается в хранилище S3, которое синхронизируется с компонентами Airflow.

Взаимодействие с хранилищем S3 происходит через утилиту s3cmd.

Файл в бакет s3 кл�адется с помощью команды s3cmd put:

s3cmd put test_join.py s3://sdpan-airflow-dags-test/test_join.py

Проверить файл в бакете s3 можно с помощью команды s3cmd ls:

s3cmd ls s3://sdpan-airflow-dags-test

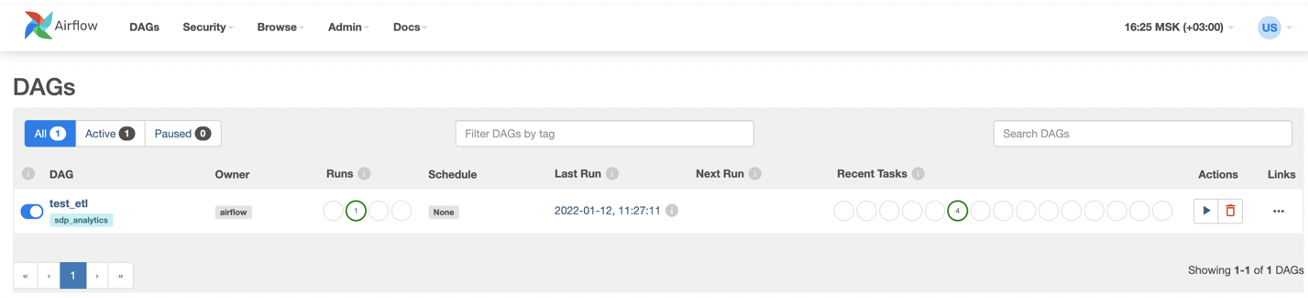

После синхронизации DAG появляется в интерфейсе Airflow

DAG запускается непосредственно из Airflow нажатием на кнопку в веб-интерфейсе, по настроенному расписанию или по наступлению определенного события.

В интерфейсе Airflow возможно представить DAG непосредственно в виде ациклического графа, либо в виде цепочки связанных тасков. См. → Работа с дагами Airflow